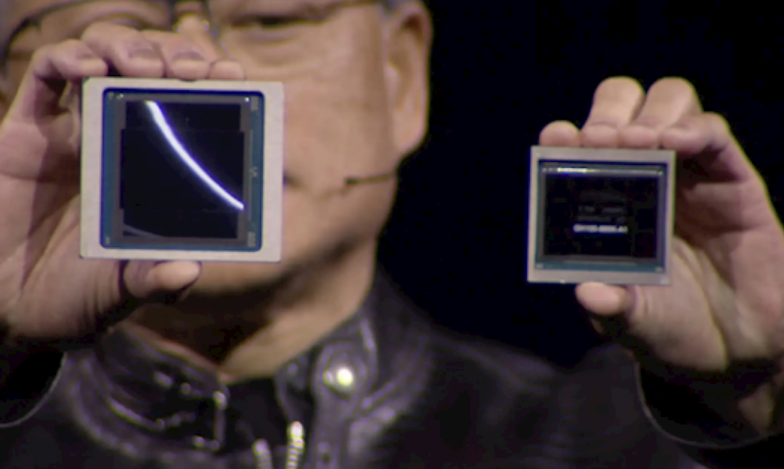

在整个AI算力硬件的搭建中,英伟达毫无疑问站在最顶端,其GPU的动态发展,直接关乎了行业的发展。

在今天开幕的GTC 2024上,黄仁勋带来了新的B200 GPU,其拥有2080亿个晶体管,可提供高达20petaflops的FP4算力。

至于GB200,就是将两个GPU和一个Grace CPU结合在一起,可为LLM推理工作负载提供30倍的性能,同时还可能大大提高效率。

英伟达也形象给出了提升的高度,比如训练一个1.8万亿个参数的模型以前需要8000个Hopper GPU和15兆瓦的电力。如今,2000个Blackwell GPU就能完成这项工作,耗电量仅为4兆瓦。

在具有1750亿个参数的GPT-3 LLM基准测试中,GB200的性能是H100的7倍,而训练速度是H100的4倍。这些显著性能的提升下,新一代 NVLink交换机起到了关键效果,可让576个GPU相互连接,双向带宽达到每秒1.8TB。

按照黄仁勋的说法,搭载B200芯片的GB200 Grace Blackwell计划今年晚些时候发货,英伟达目前并未公布GB200以及整套方案的售价信息,但目前的现状是有钱你也不一定能买到,中国厂商也是看看就行了。

黄仁勋表示,Blackwell带来了“令人难以置信的兴奋”:“我们将会把Blackwell推广给全球的AI公司,全球各地都在签约启动Blackwell,这款Blackwell将成为我们历史上最成功的产品发布。”

Blackwell平台能够在万亿参数级的大型语言模型(LLM)上构建和运行实时生成式AI,而成本和能耗比前身低25倍。